传统智慧说:"如果你不想让你的数据被使用,那就退出一切。"

我们说: "既然你的数据终将被收集,那么更明智的做法是影响其使用方式。"

不是:“企业应该拥有我的数据吗?”(他们已经拥有了)。

真正的问题是: "我的数据是否应该用于构建更优质的人工智能,造福所有人?"

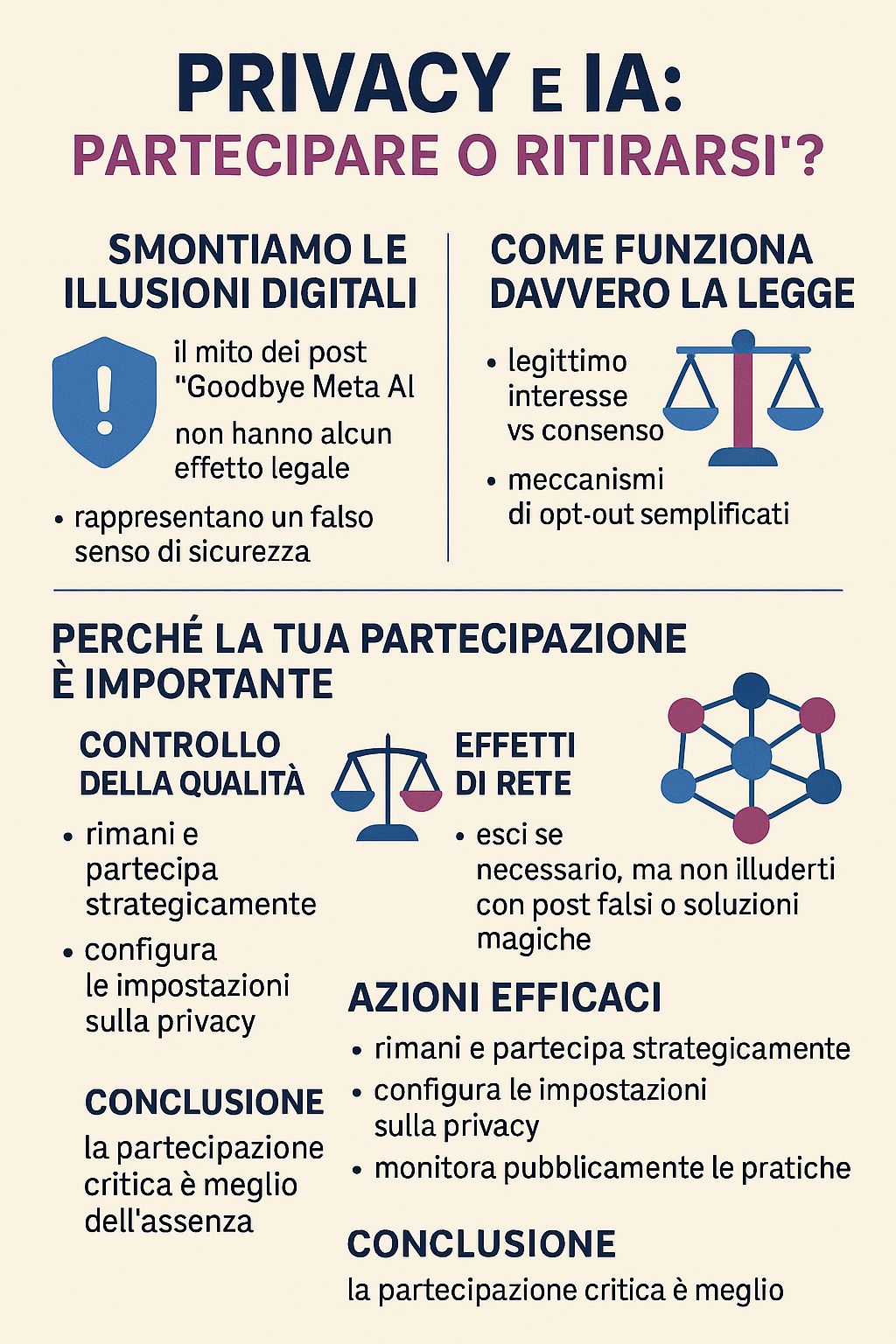

在构建严谨的论证之前,必须先破除社交媒体上流传的一个危险迷思:那些承诺只需分享一条消息就能保护你数据的病毒式传播帖子——"再见Meta AI"。

令人不安的事实:这些帖子完全是假的,可能会让你更容易受到伤害。

正如Meta自身所解释的,"分享'Goodbye Meta AI'的信息并不构成有效的反对形式"。这些帖子:

这些帖子引发的病毒式传播揭示了一个更深层的问题:我们更倾向于选择简单而虚幻的解决方案,而非做出复杂而明智的决策。分享帖子让我们感觉自己积极参与其中,却无需费心真正理解数字权利的运作机制。

但隐私无法靠网络梗来守护。守护隐私需要知识和有意识的行动。

自2025年5月31日起,Meta公司实施了一项新的AI训练制度,其法律依据从"同意"转变为"合法利益"。这并非规避手段,而是《通用数据保护条例》(GDPR)所允许的法律工具。

合法利益允许企业在无需明确同意的情况下处理数据,前提是企业能够证明其利益不会凌驾于用户权利之上。这形成了一个灰色地带,企业可通过内部评估来"量身定制法律"。

使用非匿名化数据会带来"模型逆转、记忆泄露和提取漏洞的高风险"。所需的计算能力意味着只有能力极强的行为体才能有效利用这些数据,从而在公民与大型企业之间造成系统性不对称。

既然我们已经厘清了法律和技术层面的现实情况,现在就来构建战略参与的论点。

当有意识的人选择退出时,人工智能便开始对剩余人群进行训练。你希望人工智能系统主要基于以下人群的数据吗:

人工智能中的偏见源于训练数据缺乏代表性。您的参与有助于确保:

人工智能系统随着规模和多样性的增加而不断改进:

若您使用基于人工智能的功能(搜索、翻译、推荐、辅助工具),您的参与将有助于改进这些功能,使所有用户(包括未来最需要这些功能的用户)都能受益。

无论选择加入还是退出人工智能,您的隐私都不会发生重大变化。相同的数据已经为以下方面提供支持:

区别在于这些数据是否有助于改善所有人的人工智能,还是仅服务于平台的短期商业利益。

这正是像你这样负责任的人应该参与的原因。退缩并不能阻止人工智能的发展,只会让你在其中失去话语权。

人工智能系统终将被开发出来。问题在于:这将是在有或没有那些对这些问题进行批判性思考的人们的参与下实现的?

可以理解。但请考虑这一点:你更希望人工智能系统是在 有或没有那些与你一样对大公司持怀疑态度的人参与的情况下构建的?

你的不信任恰恰是你批判性参与的价值所在。

人工智能正在成为现实,无论你是否参与其中。

你的选择并非在于人工智能是否会被创造出来,而在于即将被创造出来的人工智能是否能反映那些认真思考这些问题的人们的价值观和观点。

选择退出就像不投票。这不会阻止选举,只是意味着结果不会考虑你的贡献。

在一个唯有具备超高计算能力的参与者才能有效解读并利用这些数据的世界里,你在训练过程中的批判性声音所产生的影响,可能远超你的缺席。

若满足以下条件,请留下来并参与战略决策:

与此同时:

但别被以下说法蒙蔽:

你的个人退出对隐私影响甚微,但留下来却对所有人产生实质影响。

在一个由人工智能系统主导信息流、决策过程以及人与技术互动的世界里,问题不在于这些系统是否应该存在,而在于它们是否应当纳入像你这样善于思考且富有批判精神的人们的观点。

有时,最激进的行动并非放弃。往往最激进的方式是坚守阵地,确保自己的声音被倾听。

匿名

这并非要盲目信任企业或忽视隐私问题。关键在于认识到,隐私的守护并非依靠网络梗图,而是需要战略性的、有意识的参与。

在一个权力不对称现象极其严重的生态系统中,你在人工智能训练过程中发出的批判之声,其影响力可能远超你抗议式的缺席。

无论你做出何种选择,都要明智地选择,而非被数字幻象所迷惑。

对"隐私隐士"们也表示同情——那些纯洁的灵魂,他们相信只要像2025年的西藏僧侣那样离线生活,就能完全逃脱数字追踪。

剧透:即便你搬到多洛米蒂山脉的偏僻山间小屋居住,你的数据早已无处不在。你的家庭医生使用数字化系统。存放你购买柴火储蓄的银行追踪着每笔交易。村里的超市装有监控摄像头和电子支付系统。就连给你送账单的邮递员,也为物流数据集贡献着数据,这些数据最终会输入优化算法。

2025年彻底的数字隐居,本质上意味着自我隔绝于文明社会。你可以放弃Instagram,但若放弃医疗、银行、教育或工作体系,必将对生活质量造成灾难性后果。

当你忙着搭建自己的反5G小屋时,你的数据依然存在于医院、银行、保险公司、市政厅、税务局的数据库中,并继续被用于训练那些将影响未来几代人的系统。

隐士的悖论:你抗议式的自我隔离并不能阻止人工智能系统利用那些缺乏意识的人们的数据进行训练,反而让你丧失了引导其向更合乎伦理方向发展的机会。

本质上,你赢得了那些从看台旁观历史者所具备的纯粹道德纯洁性,而其他人——虽不那么开明却更具存在感——正在书写游戏规则。

无论你做出何种选择,都要明智地选择,而非被数字幻象所迷惑。

引用文章:

深入解析GDPR与合法利益:

官方资源:

具体操作指南:若您身处欧洲,请向隐私保护机构核实官方退出程序。如需获取通用信息,请查阅您所使用平台的隐私设置及服务条款。请谨记:社交媒体上的任何帖子均不具备法律效力。