在过去的几个月里,苹果公司发表的两篇颇具影响力的研究论文引发了人工智能界的激烈讨论。第一篇是 "思维的幻觉"(illusion-of-thinking-the-debate-that-is-shaking-the-world-of-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Symbolic"(2024 年 10 月),第二篇是 "思维的幻觉"(" The Illusion of Thinking")、 "思考的幻觉"(2025 年 6 月(2025年6月),对所谓的大型语言模型的推理能力提出了质疑,在业界引起了不同的反响。

正如我们在先前深入探讨中分析的那样 《进步的幻觉:模拟通用人工智能却无法实现》,人工智能推理问题触及了我们对机器智能认知的核心本质。

苹果公司的研究人员对大型推理模型(Large Reasoning Models,LRM)进行了系统分析,这些模型在提供答案之前会生成详细的推理轨迹。分析结果令人吃惊,对许多人来说更是令人震惊。

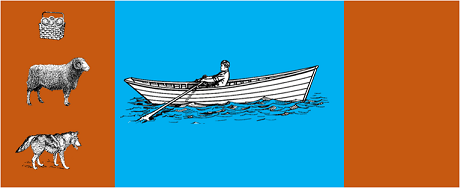

这项研究对最先进的模型进行了经典算法解谜,例如

结果表明,即使问题表述的微小变化也会导致成绩的显著变化,这表明推理的脆弱性令人担忧。正如 AppleInsider 报道当仅改变 GSM 符号基准问题中的数值时,所有模型的性能都会下降"。

很快,人工智能界就做出了回应。Open Philanthropy 的 Alex Lawsen 与 Anthropic 的 Claude Opus 合作发表了一篇题为 "The Illusion of Thinking "的详细反驳文章。 "思考的幻觉对苹果公司的研究方法和结论提出了质疑。

当劳森用其他方法重复测试时--要求模型生成递归函数,而不是列出所有棋步--结果却大相径庭。克劳德、gemini和 GPT 等模型正确地解决了河内塔问题,并有 15 条记录,远远超出了苹果公司报告的零成功的复杂度。

加里-马库斯马库斯(Gary Marcus)长期批评法学硕士的推理能力,他认为苹果公司的研究结果证实了他长达20年的理论。马库斯认为,法学硕士仍然在 "分布转移"--即超越训练数据的概括能力--方面挣扎,而他们仍然是 "已经解决的问题的优秀解决者"。

讨论还蔓延到了一些专业社区,如 Reddit 上的上的 LocalLlama 等专业社区,开发人员和研究人员在那里讨论开源模式和本地实施的实际意义。

这场辩论并不纯粹是学术性的。它直接影响到:

正如一些 技术见解越来越需要将以下方面结合起来的混合方法:

举个简单的例子:人工智能助理帮助记账。当你问 "我这个月在旅行上花了多少钱?"时,语言模型会理解并提取相关参数(类别:旅行,时间:本月)。但查询数据库、计算总和并检查财务约束的 SQL 查询呢?这是由确定性代码完成的,而不是神经模型。

观察家们注意到,苹果公司的这份文件是在 WWDC 前不久发表的,这不禁让人怀疑其战略动机。正如9to5Mac 的分析的分析,"苹果论文发表的时间--就在 WWDC 之前--引起了一些人的关注。这是一个研究里程碑,还是苹果在更广泛的人工智能领域重新定位的战略举措?

苹果公司的论文引发的争论提醒我们,我们对人工智能的理解仍处于早期阶段。正如我们在 上一篇文章中指出的,区分模拟推理和真实推理仍然是我们这个时代最复杂的挑战之一。

真正的教训并不在于 LLM 能否进行人类意义上的 "推理",而在于我们如何才能构建既能利用其优势又能弥补其局限性的系统。在人工智能已经改变整个行业的今天,问题不再是这些工具是否 "聪明",而是如何有效、负责任地使用它们。

企业人工智能的未来可能不在于单一的革命性方法,而在于几种互补技术的智能协调。在这种情况下,批判性地、诚实地评估我们工具能力的能力本身就是一种竞争优势。

最新进展(2026年1月)

OpenAI发布o3和o4-mini:2025年4月16日,OpenAI正式公开发布o3和o4-mini——这是o系列中最先进的推理模型。这些模型现可自主运用工具,融合网络搜索、文件分析、视觉推理与图像生成能力。 o3在Codeforces、SWE-bench和MMMU等基准测试中创下新纪录,而o4-mini则针对高吞吐量推理任务优化了性能与成本。这些模型展现出"图像思维"能力,可通过视觉转换内容实现更深入的分析。

DeepSeek-R1震撼人工智能行业:2025年1月,DeepSeek发布开源推理模型R1,其性能可媲美OpenAI o1,而训练成本仅需600万美元(西方同类模型需数亿美元)。 DeepSeek-R1证明推理能力可通过纯强化学习实现,无需人工标注示范。该模型在数十个国家成为App Store和Google Play免费榜冠军应用。 2026年1月,DeepSeek发布了60页的扩展论文,揭示了训练秘诀,并坦率承认蒙特卡洛树搜索(MCTS)等技术无法实现通用推理。

Anthropic更新Claude的"宪法":2026年1月22日,Anthropic为Claude发布了长达23,000字的新宪法,将伦理框架从规则导向转变为基于伦理原则的理解。 该文件成为首份正式承认人工智能可能具备意识或道德地位的大型人工智能企业框架,声明Anthropic关注Claude的"心理健康、自我认知与福祉"。

争论愈演愈烈:2025年7月的一项研究复现并优化了苹果公司的基准测试,证实当复杂度适度提升(约8个圆盘的河内塔)时,LRM仍会显现认知局限。研究人员证明这不仅源于输出限制,更源于真实的认知边界,表明这场争论远未结束。

如需深入了解贵组织的人工智能战略并实施稳健的解决方案,我们的专家团队可为您提供定制咨询。